[ad_1]

Khi nói đến trí tuệ nhân tạo, vẻ bề ngoài có thể đánh lừa. Bí ẩn xung quanh hoạt động bên trong của các mô hình ngôn ngữ lớn (LLM) bắt nguồn từ kích thước lớn, phương pháp đào tạo phức tạp, hành vi khó dự đoán và khả năng diễn giải khó nắm bắt của chúng.

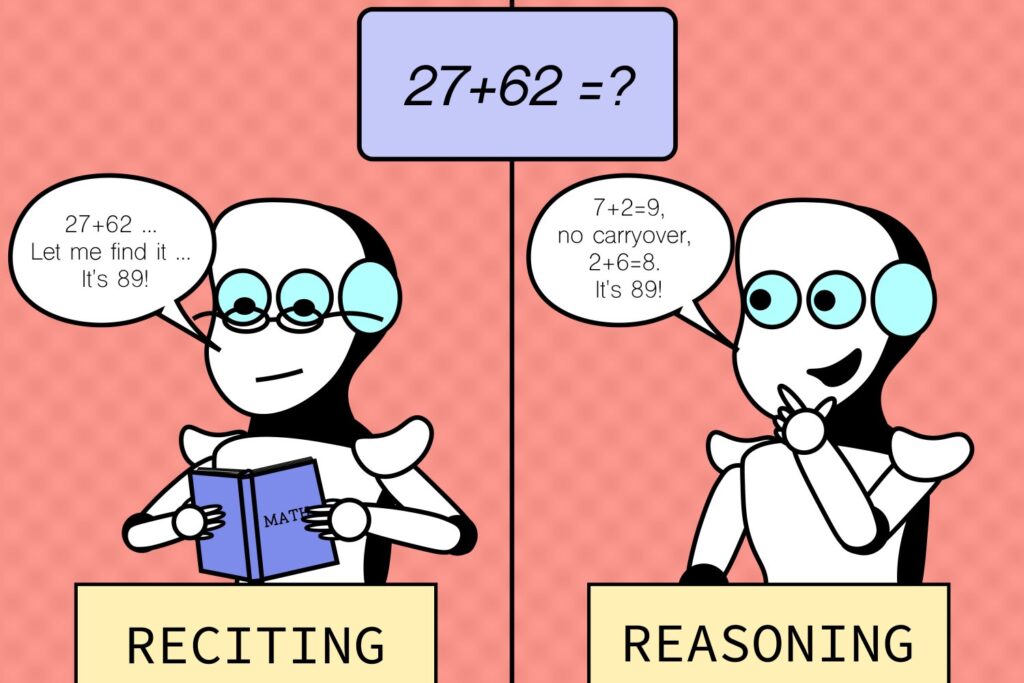

Các nhà nghiên cứu tại Phòng thí nghiệm Khoa học máy tính và Trí tuệ nhân tạo (CSAIL) của MIT gần đây đã nhìn vào kính lúp để xem xét cách các LLM xử lý các biến thể của các nhiệm vụ khác nhau, tiết lộ những hiểu biết thú vị về sự tương tác giữa kỹ năng ghi nhớ và lý luận. Hóa ra khả năng lý luận của họ thường bị đánh giá quá cao.

Nghiên cứu đã so sánh “các nhiệm vụ mặc định”, các nhiệm vụ chung mà một mô hình được đào tạo và thử nghiệm, với “các tình huống phản thực tế”, các tình huống giả định khác với các điều kiện mặc định — mà các mô hình như GPT-4 và Claude thường có thể xử lý được. Các nhà nghiên cứu đã phát triển một số bài kiểm tra nằm ngoài vùng thoải mái của các mô hình bằng cách điều chỉnh các nhiệm vụ hiện có thay vì tạo ra các nhiệm vụ hoàn toàn mới. Họ đã sử dụng nhiều tập dữ liệu và điểm chuẩn được thiết kế riêng cho các khía cạnh khác nhau về khả năng của các mô hình đối với những thứ như số học, cờ vua, đánh giá mã, trả lời các câu hỏi logic, v.v.

Khi người dùng tương tác với các mô hình ngôn ngữ, bất kỳ phép tính số học nào thường ở cơ số 10, cơ số số quen thuộc với các mô hình. Nhưng việc quan sát thấy chúng hoạt động tốt ở cơ số 10 có thể khiến chúng ta có ấn tượng sai lầm rằng chúng có năng lực mạnh về phép cộng. Về mặt logic, nếu chúng thực sự sở hữu các kỹ năng cộng tốt, bạn sẽ mong đợi hiệu suất cao đáng tin cậy trên tất cả các cơ số số, tương tự như máy tính bỏ túi hoặc máy tính. Thật vậy, nghiên cứu cho thấy các mô hình này không mạnh mẽ như nhiều người nghĩ ban đầu. Hiệu suất cao của chúng chỉ giới hạn ở các biến thể nhiệm vụ phổ biến và bị giảm hiệu suất liên tục và nghiêm trọng trong các tình huống phản thực tế không quen thuộc, cho thấy thiếu khả năng cộng có thể khái quát hóa.

Mẫu hình này vẫn đúng với nhiều nhiệm vụ khác như bấm hợp âm, lý luận không gian và thậm chí là các bài toán cờ vua, trong đó vị trí bắt đầu của các quân cờ đã thay đổi đôi chút. Trong khi người chơi vẫn được kỳ vọng có thể xác định tính hợp lệ của các nước đi trong các tình huống thay đổi (nếu có đủ thời gian), các mô hình đã gặp khó khăn và không thể thực hiện tốt hơn việc đoán ngẫu nhiên, nghĩa là chúng có khả năng khái quát hóa hạn chế đối với các tình huống không quen thuộc. Và phần lớn hiệu suất của chúng đối với các nhiệm vụ tiêu chuẩn có thể không phải do khả năng thực hiện nhiệm vụ chung, mà là do quá khớp với hoặc ghi nhớ trực tiếp từ những gì chúng đã thấy trong dữ liệu đào tạo của mình.

Zhaofeng Wu, một nghiên cứu sinh tiến sĩ về kỹ thuật điện và khoa học máy tính tại MIT, chi nhánh của CSAIL và là tác giả chính của một bài báo mới, cho biết: “Chúng tôi đã khám phá ra một khía cạnh hấp dẫn của các mô hình ngôn ngữ lớn: chúng nổi trội trong các tình huống quen thuộc, gần giống như một con đường mòn, nhưng lại gặp khó khăn khi địa hình trở nên xa lạ. Nhận thức này rất quan trọng khi chúng tôi nỗ lực nâng cao khả năng thích ứng của các mô hình này và mở rộng tầm nhìn ứng dụng của chúng”. giấy về nghiên cứu. “Khi AI ngày càng trở nên phổ biến trong xã hội của chúng ta, nó phải xử lý đáng tin cậy các tình huống đa dạng, dù quen thuộc hay không. Chúng tôi hy vọng những hiểu biết sâu sắc này một ngày nào đó sẽ cung cấp thông tin cho việc thiết kế các LLM trong tương lai với độ mạnh mẽ được cải thiện.”

Bất chấp những hiểu biết sâu sắc thu được, tất nhiên vẫn có những hạn chế. Nghiên cứu tập trung vào các nhiệm vụ và cài đặt cụ thể không nắm bắt được toàn bộ phạm vi thách thức mà các mô hình có thể gặp phải trong các ứng dụng thực tế, báo hiệu nhu cầu về các môi trường thử nghiệm đa dạng hơn. Công việc trong tương lai có thể bao gồm việc mở rộng phạm vi nhiệm vụ và các điều kiện phản thực tế để khám phá thêm nhiều điểm yếu tiềm ẩn. Điều này có nghĩa là phải xem xét các kịch bản phức tạp hơn và ít phổ biến hơn. Nhóm cũng muốn cải thiện khả năng diễn giải bằng cách tạo ra các phương pháp để hiểu rõ hơn lý do đằng sau các quy trình ra quyết định của mô hình.

“Khi các mô hình ngôn ngữ mở rộng quy mô, việc hiểu dữ liệu đào tạo của chúng ngày càng trở nên khó khăn ngay cả đối với các mô hình mở, chứ chưa nói đến các mô hình độc quyền”, Hao Peng, phó giáo sư tại Đại học Illinois tại Urbana-Champaign cho biết. “Cộng đồng vẫn còn bối rối về việc liệu các mô hình này có thực sự khái quát hóa cho các nhiệm vụ chưa từng thấy hay có vẻ thành công bằng cách ghi nhớ dữ liệu đào tạo hay không. Bài báo này đã có những bước tiến quan trọng trong việc giải quyết câu hỏi này. Bài báo xây dựng một bộ đánh giá phản thực tế được thiết kế cẩn thận, cung cấp những hiểu biết mới về khả năng của các LLM tiên tiến. Bài báo cho thấy khả năng giải quyết các nhiệm vụ chưa từng thấy của chúng có lẽ còn hạn chế hơn nhiều so với dự đoán của nhiều người. Bài báo có tiềm năng truyền cảm hứng cho các nghiên cứu trong tương lai nhằm xác định các chế độ lỗi của các mô hình hiện nay và phát triển các mô hình tốt hơn”.

Các tác giả khác bao gồm Najoung Kim, phó giáo sư của Đại học Boston và là nhà nghiên cứu thỉnh giảng của Google, cùng bảy chi nhánh của CSAIL: các nghiên cứu sinh tiến sĩ ngành kỹ thuật điện và khoa học máy tính (EECS) của MIT là Linlu Qiu, Alexis Ross, Ekin Akyürek SM ’21 và Boyuan Chen; cựu tiến sĩ sau tiến sĩ và nhà nghiên cứu AI/ML của Apple là Bailin Wang; và phó giáo sư EECS là Jacob Andreas và Yoon Kim.

Nghiên cứu của nhóm được hỗ trợ một phần bởi Phòng thí nghiệm AI Watson của MIT–IBM, MIT Quest for Intelligence và Quỹ khoa học quốc gia. Nhóm đã trình bày công trình tại Chi nhánh Bắc Mỹ của Hiệp hội ngôn ngữ học tính toán (NAACL) vào tháng trước.

[ad_2]

Source link