[ad_1]

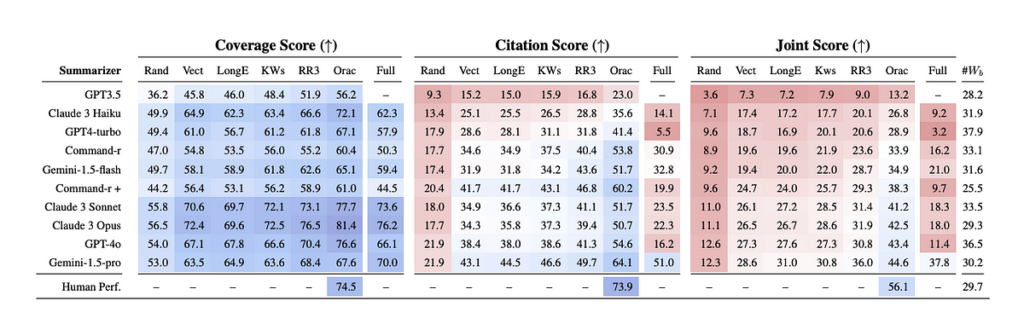

Gemini Professional có thể xử lý một bối cảnh token đáng kinh ngạc là 2M so với con số 15k ít ỏi mà chúng ta đã kinh ngạc khi GPT-3.5 hạ cánh. Điều đó có nghĩa là chúng ta không còn quan tâm đến hệ thống truy xuất hoặc RAG nữa không? Dựa trên Tiêu chuẩn Needle-in-a-Haystackcâu trả lời là trong khi nhu cầu đang giảm dần, đặc biệt là đối với các mô hình Gemini, các kỹ thuật truy xuất tiên tiến vẫn cải thiện đáng kể hiệu suất cho hầu hết các LLM. Kết quả đánh giá chuẩn cho thấy các mô hình ngữ cảnh dài hoạt động tốt khi đưa ra những hiểu biết cụ thể. Tuy nhiên, chúng gặp khó khăn khi cần trích dẫn. Điều đó làm cho các kỹ thuật truy xuất đặc biệt quan trọng đối với các trường hợp sử dụng mà chất lượng trích dẫn là quan trọng (ví dụ như luật pháp, báo chí và các ứng dụng y tế). Những ứng dụng này có xu hướng có giá trị cao hơn, trong đó việc thiếu trích dẫn khiến thông tin chi tiết ban đầu kém hữu ích hơn nhiều. Ngoài ra, trong khi chi phí của các mô hình ngữ cảnh dài có thể sẽ giảm, việc tăng cường các mô hình cửa sổ nội dung ngắn hơn bằng các trình truy xuất có thể là một con đường tiết kiệm chi phí và có độ trễ thấp hơn để phục vụ cùng các trường hợp sử dụng. Có thể nói rằng RAG và truy xuất sẽ tồn tại lâu hơn một thời gian nhưng có thể bạn sẽ không nhận được nhiều lợi ích khi triển khai một hệ thống RAG ngây thơ.

Superior RAG bao gồm nhiều kỹ thuật nhưng nhìn chung chúng nằm trong phạm vi viết lại truy vấn trước khi truy xuất và xếp hạng lại sau khi truy xuất. Hãy cùng tìm hiểu sâu hơn về từng kỹ thuật.

H: “Ý nghĩa của cuộc sống là gì?”

A: “42”

Sự bất đối xứng giữa câu hỏi và câu trả lời là một vấn đề lớn trong các hệ thống RAG. Một cách tiếp cận điển hình đối với các hệ thống RAG đơn giản hơn là so sánh độ tương đồng cosin của truy vấn và nhúng tài liệu. Cách này hiệu quả khi câu hỏi gần như được nêu lại trong câu trả lời, “Con vật yêu thích của Meghan là gì?”, “Con vật yêu thích của Meghan là hươu cao cổ.”, nhưng chúng ta hiếm khi might mắn như vậy.

Sau đây là một số kỹ thuật có thể khắc phục điều này:

Thuật ngữ “Viết lại-Lấy lại-Đọc” có nguồn gốc từ một giấy từ nhóm Microsoft Azure vào năm 2023 (mặc dù xét đến tính trực quan của kỹ thuật này, nó đã được sử dụng trong một thời gian). Trong nghiên cứu này, một LLM sẽ viết lại truy vấn của người dùng thành truy vấn được tối ưu hóa cho công cụ tìm kiếm trước khi tìm kiếm ngữ cảnh có liên quan để trả lời câu hỏi.

Ví dụ chính là cách truy vấn này, “Nicholas Ray và Elia Kazan có chung nghề nghiệp gì?” nên được chia thành hai truy vấn, “Nghề nghiệp của Nicholas Ray” Và “Nghề nghiệp của Elia Kazan”. Điều này cho phép có kết quả tốt hơn vì không có khả năng một tài liệu duy nhất có thể chứa câu trả lời cho cả hai câu hỏi. Bằng cách chia truy vấn thành hai, trình truy xuất có thể truy xuất hiệu quả hơn các tài liệu có liên quan.

Viết lại cũng có thể giúp khắc phục các vấn đề phát sinh từ “lời nhắc bị phân tâm”. Hoặc các trường hợp truy vấn của người dùng có các khái niệm hỗn hợp trong lời nhắc của họ và việc nhúng trực tiếp sẽ dẫn đến vô nghĩa. Ví dụ: “Tuyệt, cảm ơn vì đã cho tôi biết Thủ tướng Anh là ai. Bây giờ hãy cho tôi biết Tổng thống Pháp là ai” sẽ được viết lại như thế này “tổng thống Pháp hiện tại”. Điều này có thể giúp ứng dụng của bạn trở nên mạnh mẽ hơn đối với nhiều người dùng hơn vì một số người sẽ suy nghĩ nhiều về cách diễn đạt lời nhắc của họ một cách tối ưu, trong khi những người khác có thể có các chuẩn mực khác.

Trong việc mở rộng truy vấn với LLM, truy vấn ban đầu có thể được viết lại thành nhiều câu hỏi được diễn đạt lại hoặc phân tích thành các câu hỏi phụ. Lý tưởng nhất là bằng cách mở rộng truy vấn thành nhiều tùy chọn, khả năng chồng chéo từ vựng sẽ tăng lên giữa truy vấn ban đầu và tài liệu chính xác trong thành phần lưu trữ của bạn.

Mở rộng truy vấn là một khái niệm có từ trước khi LLM được sử dụng rộng rãi. Phản hồi liên quan giả (PRF) là một kỹ thuật truyền cảm hứng cho một số nhà nghiên cứu LLM. Trong PRF, các tài liệu được xếp hạng cao nhất từ tìm kiếm ban đầu để xác định và đánh giá các thuật ngữ truy vấn mới. Với LLM, chúng tôi dựa vào khả năng sáng tạo và tạo ra của mô hình để tìm các thuật ngữ truy vấn mới. Điều này có lợi vì LLM không bị giới hạn trong tập hợp tài liệu ban đầu và có thể tạo ra các thuật ngữ mở rộng không được bao phủ bởi các phương pháp truyền thống.

Mở rộng truy vấn theo ngữ liệu (CSQE) là phương pháp kết hợp cách tiếp cận PRF truyền thống với khả năng tạo ra của LLM. Các tài liệu được truy xuất ban đầu được phản hồi lại LLM để tạo ra các thuật ngữ truy vấn mới cho tìm kiếm. Kỹ thuật này có thể đặc biệt hiệu quả đối với các truy vấn mà LLM không có kiến thức về chủ đề.

Có những hạn chế đối với cả việc mở rộng truy vấn dựa trên LLM và những người tiền nhiệm của nó như PRF. Trong đó, rõ ràng nhất là giả định rằng các thuật ngữ do LLM tạo ra có liên quan hoặc các kết quả được xếp hạng cao nhất có liên quan. Xin Chúa cấm tôi cố gắng tìm thông tin về nhà báo người Úc Harry Potter thay vì cậu bé phù thủy nổi tiếng. Cả hai kỹ thuật sẽ kéo truy vấn của tôi ra khỏi chủ đề truy vấn ít phổ biến hơn sang chủ đề phổ biến hơn khiến các truy vấn trường hợp ngoại lệ kém hiệu quả hơn.

Một cách khác để giảm sự bất đối xứng giữa các câu hỏi và tài liệu là lập chỉ mục các tài liệu với một tập hợp các câu hỏi giả định do LLM tạo ra. Đối với một tài liệu nhất định, LLM có thể tạo ra các câu hỏi có thể được trả lời bằng tài liệu. Sau đó, trong bước truy xuất, nhúng truy vấn của người dùng được so sánh với nhúng câu hỏi giả định so với nhúng tài liệu.

Điều này có nghĩa là chúng ta không cần nhúng khối tài liệu gốc, thay vào đó, chúng ta có thể gán cho khối một ID tài liệu và lưu trữ dưới dạng siêu dữ liệu trên tài liệu câu hỏi giả định. Việc tạo ID tài liệu có nghĩa là sẽ có ít chi phí hơn khi ánh xạ nhiều câu hỏi vào một tài liệu.

Nhược điểm rõ ràng của cách tiếp cận này là hệ thống của bạn sẽ bị giới hạn bởi tính sáng tạo và khối lượng câu hỏi bạn lưu trữ.

HyDE là đối lập với Chỉ mục truy vấn giả thuyết. Thay vì tạo ra các câu hỏi giả thuyết, LLM được yêu cầu tạo ra một tài liệu giả thuyết có thể trả lời câu hỏi và nhúng tài liệu được tạo đó được sử dụng để tìm kiếm trên các tài liệu thực. Tài liệu thực sau đó được sử dụng để tạo phản hồi. Phương pháp này cho thấy sự cải thiện mạnh mẽ so với các phương pháp truy xuất hiện đại khác khi lần đầu tiên được giới thiệu vào năm 2022.

Chúng tôi sử dụng khái niệm này tại Dune cho sản phẩm ngôn ngữ tự nhiên sang SQL của mình. Bằng cách viết lại lời nhắc của người dùng dưới dạng chú thích hoặc tiêu đề có thể có cho biểu đồ có thể trả lời câu hỏi, chúng tôi có thể truy xuất tốt hơn các truy vấn SQL có thể đóng vai trò là ngữ cảnh cho LLM để viết truy vấn mới.

[ad_2]

Source link