[ad_1]

Các mô hình nền tảng là các mô hình học sâu khổng lồ đã được đào tạo trước trên một lượng lớn dữ liệu mục đích chung, không có nhãn. Chúng có thể được áp dụng cho nhiều tác vụ khác nhau, như tạo hình ảnh hoặc trả lời câu hỏi của khách hàng.

Nhưng những mô hình này, đóng vai trò là xương sống cho các công cụ trí tuệ nhân tạo mạnh mẽ như ChatGPT và DALL-E, có thể cung cấp thông tin không chính xác hoặc gây hiểu lầm. Trong tình huống quan trọng về an toàn, chẳng hạn như người đi bộ đang đến gần một chiếc xe tự lái, những sai lầm này có thể gây ra hậu quả nghiêm trọng.

Để giúp ngăn ngừa những sai lầm như vậy, các nhà nghiên cứu từ MIT và Phòng thí nghiệm AI Watson của MIT-IBM đã phát triển một kỹ thuật để ước tính độ tin cậy của các mô hình nền tảng trước khi triển khai chúng cho một nhiệm vụ cụ thể.

Họ thực hiện điều này bằng cách đào tạo một tập hợp các mô hình nền tảng hơi khác nhau. Sau đó, họ sử dụng thuật toán của mình để đánh giá tính nhất quán của các biểu diễn mà mỗi mô hình học được về cùng một điểm dữ liệu thử nghiệm. Nếu các biểu diễn nhất quán, điều đó có nghĩa là mô hình đáng tin cậy.

Khi họ so sánh kỹ thuật của mình với các phương pháp cơ sở hiện đại, phương pháp này có khả năng nắm bắt độ tin cậy của các mô hình nền tảng trên nhiều nhiệm vụ phân loại khác nhau tốt hơn.

Ai đó có thể sử dụng kỹ thuật này để quyết định xem một mô hình có nên được áp dụng trong một bối cảnh nhất định hay không, mà không cần phải thử nghiệm nó trên một tập dữ liệu thực tế. Điều này có thể đặc biệt hữu ích khi các tập dữ liệu có thể không thể truy cập được do các vấn đề về quyền riêng tư, chẳng hạn như trong các bối cảnh chăm sóc sức khỏe. Ngoài ra, kỹ thuật này có thể được sử dụng để xếp hạng các mô hình dựa trên điểm tin cậy, cho phép người dùng chọn mô hình tốt nhất cho nhiệm vụ của họ.

“Tất cả các mô hình đều có thể sai, nhưng các mô hình biết khi nào chúng sai thì hữu ích hơn. Vấn đề định lượng sự không chắc chắn hoặc độ tin cậy trở nên khó khăn hơn đối với các mô hình nền tảng này vì các biểu diễn trừu tượng của chúng khó so sánh. Phương pháp của chúng tôi cho phép bạn định lượng mức độ tin cậy của một mô hình biểu diễn đối với bất kỳ dữ liệu đầu vào nào được đưa ra”, tác giả cao cấp Navid Azizan, Giáo sư trợ lý Esther và Harold E. Edgerton tại Khoa Kỹ thuật cơ khí của MIT và Viện Dữ liệu, Hệ thống và Xã hội (IDSS) và là thành viên của Phòng thí nghiệm Hệ thống thông tin và Quyết định (LIDS) cho biết.

Anh ấy đã tham gia vào một bài viết về công việc của tác giả chính Younger-Jin Park, một sinh viên tốt nghiệp LIDS; Hao Wang, một nhà khoa học nghiên cứu tại Phòng thí nghiệm AI Watson của MIT-IBM; và Shervin Ardeshir, một nhà khoa học nghiên cứu cao cấp tại Netflix. Bài báo sẽ được trình bày tại Hội nghị về Sự không chắc chắn trong Trí tuệ nhân tạo.

Đếm sự đồng thuận

Các mô hình học máy truyền thống được đào tạo để thực hiện một nhiệm vụ cụ thể. Các mô hình này thường đưa ra dự đoán cụ thể dựa trên đầu vào. Ví dụ, mô hình có thể cho bạn biết một hình ảnh nhất định có chứa mèo hay chó. Trong trường hợp này, đánh giá độ tin cậy có thể chỉ là vấn đề xem xét dự đoán cuối cùng để xem mô hình có đúng không.

Nhưng các mô hình nền tảng thì khác. Mô hình được đào tạo trước bằng dữ liệu chung, trong bối cảnh mà người tạo ra nó không biết tất cả các tác vụ hạ nguồn mà nó sẽ được áp dụng. Người dùng điều chỉnh nó cho các tác vụ cụ thể của họ sau khi nó đã được đào tạo.

Không giống như các mô hình học máy truyền thống, các mô hình nền tảng không đưa ra kết quả cụ thể như nhãn “mèo” hoặc “chó”. Thay vào đó, chúng tạo ra một biểu diễn trừu tượng dựa trên điểm dữ liệu đầu vào.

Để đánh giá độ tin cậy của mô hình nền tảng, các nhà nghiên cứu đã sử dụng phương pháp tổng hợp bằng cách đào tạo một số mô hình có nhiều đặc tính chung nhưng hơi khác nhau.

“Ý tưởng của chúng tôi giống như đếm sự đồng thuận. Nếu tất cả các mô hình nền tảng đó đưa ra các biểu diễn nhất quán cho bất kỳ dữ liệu nào trong tập dữ liệu của chúng tôi, thì chúng tôi có thể nói rằng mô hình này đáng tin cậy”, Park nói.

Nhưng họ gặp phải một vấn đề: Làm sao họ có thể so sánh các biểu diễn trừu tượng?

Ông nói thêm: “Những mô hình này chỉ đưa ra một vectơ bao gồm một số con số nên chúng ta không thể dễ dàng so sánh chúng”.

Họ giải quyết vấn đề này bằng cách sử dụng ý tưởng gọi là tính nhất quán của khu vực lân cận.

Đối với cách tiếp cận của họ, các nhà nghiên cứu chuẩn bị một tập hợp các điểm tham chiếu đáng tin cậy để thử nghiệm trên tập hợp các mô hình. Sau đó, đối với mỗi mô hình, họ điều tra các điểm tham chiếu nằm gần biểu diễn điểm thử nghiệm của mô hình đó.

Bằng cách xem xét tính nhất quán của các điểm lân cận, họ có thể ước tính độ tin cậy của mô hình.

Căn chỉnh các biểu diễn

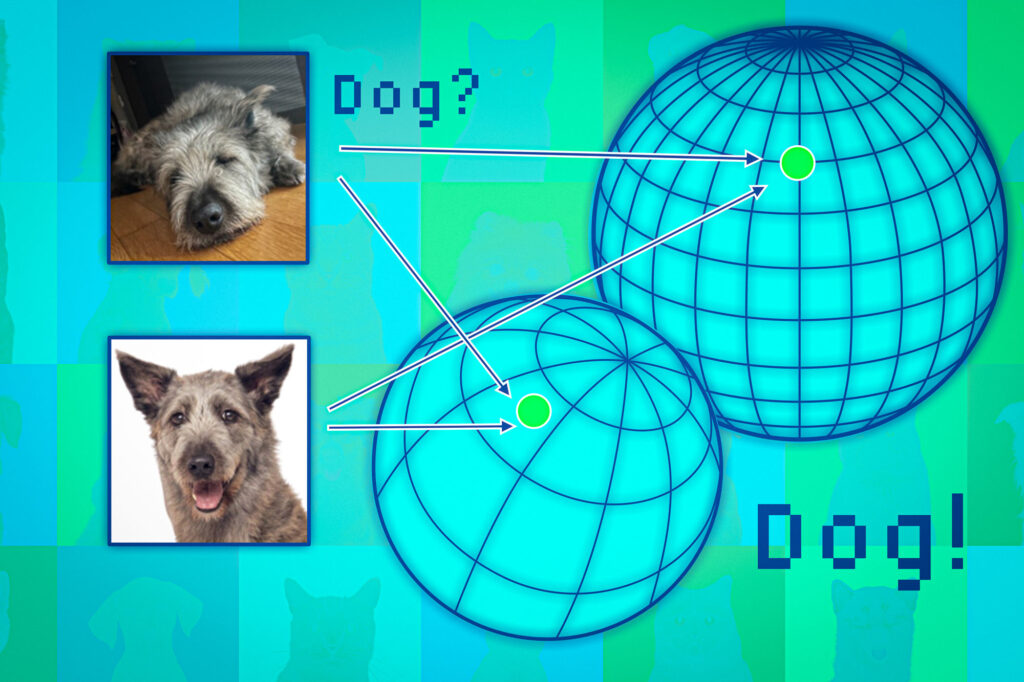

Các mô hình nền tảng ánh xạ các điểm dữ liệu trong cái được gọi là không gian biểu diễn. Một cách để nghĩ về không gian này là như một hình cầu. Mỗi mô hình ánh xạ các điểm dữ liệu tương tự vào cùng một phần của hình cầu của nó, vì vậy hình ảnh của mèo sẽ ở một nơi và hình ảnh của chó sẽ ở một nơi khác.

Nhưng mỗi mô hình sẽ lập bản đồ các loài động vật theo những cách khác nhau trong phạm vi của nó, vì vậy trong khi mèo có thể được nhóm lại gần Cực Nam của một phạm vi thì một mô hình khác có thể lập bản đồ mèo ở đâu đó ở Bắc bán cầu.

Các nhà nghiên cứu sử dụng các điểm lân cận như mỏ neo để căn chỉnh các quả cầu đó để họ có thể làm cho các biểu diễn có thể so sánh được. Nếu các điểm lân cận của một điểm dữ liệu nhất quán trên nhiều biểu diễn, thì người ta nên tự tin về độ tin cậy của đầu ra của mô hình cho điểm đó.

Khi họ thử nghiệm phương pháp này trên nhiều nhiệm vụ phân loại, họ thấy rằng nó nhất quán hơn nhiều so với các đường cơ sở. Thêm vào đó, nó không bị vấp ngã bởi các điểm thử thách khiến các phương pháp khác thất bại.

Hơn nữa, cách tiếp cận của họ có thể được sử dụng để đánh giá độ tin cậy của bất kỳ dữ liệu đầu vào nào, do đó người ta có thể đánh giá mức độ hiệu quả của một mô hình đối với một loại cá nhân cụ thể, chẳng hạn như bệnh nhân có những đặc điểm nhất định.

Wang cho biết: “Ngay cả khi tất cả các mô hình đều có hiệu suất trung bình nhìn chung, theo quan điểm cá nhân, bạn sẽ thích mô hình phù hợp nhất với cá nhân đó”.

Tuy nhiên, một hạn chế xuất phát từ thực tế là họ phải đào tạo một tập hợp các mô hình nền tảng lớn, điều này tốn kém về mặt tính toán. Trong tương lai, họ có kế hoạch tìm ra những cách hiệu quả hơn để xây dựng nhiều mô hình, có thể bằng cách sử dụng các nhiễu loạn nhỏ của một mô hình duy nhất.

Công trình này được tài trợ một phần bởi Phòng thí nghiệm AI Watson của MIT-IBM, MathWorks và Amazon.

[ad_2]

Source link