[ad_1]

Sự thiên vị của AI đề cập đến sự phân biệt đối xử khi các hệ thống AI tạo ra kết quả không bình đẳng cho các nhóm khác nhau do sự thiên vị trong dữ liệu đào tạo. Khi không được giảm thiểu, sự thiên vị trong các mô hình AI và máy học có thể hệ thống hóa và làm trầm trọng thêm sự phân biệt đối xử mà các nhóm thiểu số trong lịch sử phải đối mặt bằng cách nhúng sự phân biệt đối xử vào các thuật toán ra quyết định.

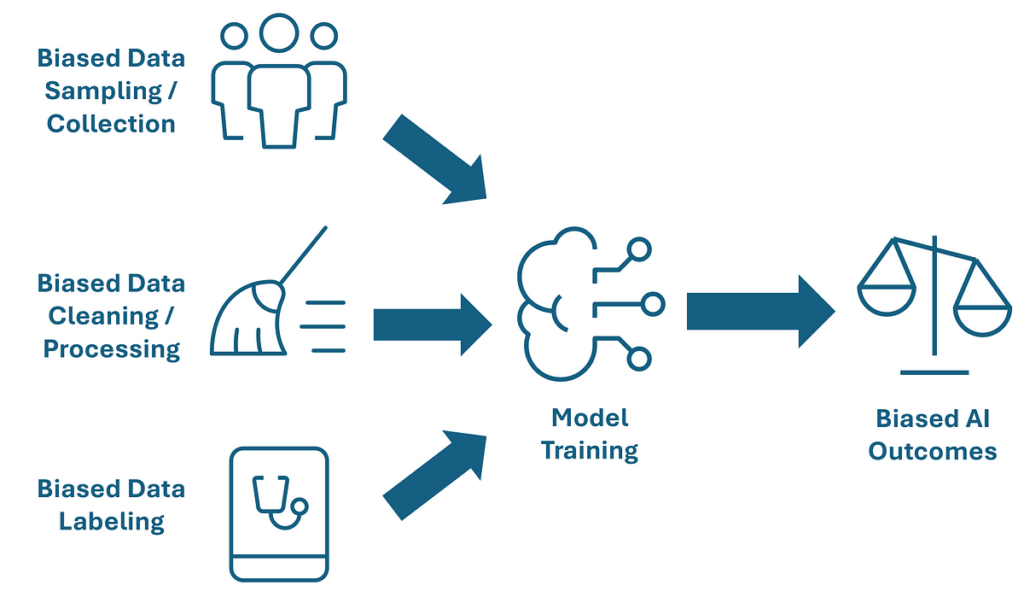

Các vấn đề trong dữ liệu đào tạo, chẳng hạn như các tập dữ liệu không đại diện hoặc mất cân bằng, định kiến lịch sử được nhúng trong dữ liệu và các phương pháp thu thập dữ liệu bị lỗi, dẫn đến các mô hình thiên vị. Ví dụ, nếu đơn xin quyết định cho vay được đào tạo về các quyết định lịch sử, nhưng những người nộp đơn xin vay vốn là người da đen đã bị phân biệt đối xử một cách có hệ thống trong các quyết định lịch sử này, thì mô hình sẽ nhúng mô hình phân biệt đối xử này vào trong quá trình ra quyết định của mình. Các thành kiến cũng có thể được đưa vào trong các giai đoạn lựa chọn và thiết kế tính năng, trong đó một số thuộc tính nhất định có thể vô tình hoạt động như đại diện cho các đặc điểm nhạy cảm như chủng tộc, giới tính hoặc tình trạng kinh tế xã hội. Ví dụ, chủng tộc và mã bưu chính có mối liên hệ chặt chẽ ở Mỹ, do đó, một thuật toán được đào tạo bằng cách sử dụng dữ liệu mã bưu chính sẽ gián tiếp nhúng thông tin về chủng tộc vào quá trình ra quyết định của nó.

AI trong bối cảnh y tế liên quan đến việc sử dụng các mô hình học máy và thuật toán để hỗ trợ chẩn đoán, lập kế hoạch điều trị và chăm sóc bệnh nhân. Sự thiên vị của AI có thể đặc biệt có hại trong những tình huống này, dẫn đến sự chênh lệch đáng kể trong việc cung cấp dịch vụ chăm sóc sức khỏe và kết quả. Ví dụ, một mô hình dự đoán ung thư da được đào tạo chủ yếu trên hình ảnh tông màu da sáng hơn có thể hoạt động kém trên bệnh nhân có làn da sẫm màu. Một hệ thống như vậy có thể gây ra chẩn đoán sai hoặc điều trị chậm trễ cho bệnh nhân có làn da sẫm màu, dẫn đến tỷ lệ tử vong cao hơn. Với rủi ro cao trong các ứng dụng chăm sóc sức khỏe, các nhà khoa học dữ liệu phải hành động để giảm thiểu sự thiên vị của AI trong các ứng dụng của họ. Bài viết này sẽ tập trung vào các kỹ thuật quản lý dữ liệu mà các nhà khoa học dữ liệu có thể thực hiện để loại bỏ sự thiên vị trong các tập huấn luyện trước khi các mô hình được đào tạo.

Để giảm thiểu sự thiên vị của AI, điều quan trọng là phải hiểu cách sự thiên vị và công bằng của mô hình được định nghĩa (PDF) và được đo lường. Một mô hình công bằng/không thiên vị đảm bảo các dự đoán của nó là công bằng giữa các nhóm khác nhau. Điều này có nghĩa là hành vi của mô hình, chẳng hạn như độ chính xác và xác suất lựa chọn, có thể so sánh được giữa các phân nhóm được xác định bởi các đặc điểm nhạy cảm (ví dụ: chủng tộc, giới tính, tình trạng kinh tế xã hội).

Sử dụng các số liệu định lượng cho tính công bằng/thiên vị của AI, chúng ta có thể đo lường và cải thiện các mô hình của riêng mình. Các số liệu này so sánh tỷ lệ chính xác và xác suất lựa chọn giữa các nhóm có đặc quyền theo lịch sử và các nhóm không có đặc quyền theo lịch sử. Ba số liệu thường được sử dụng để đo lường mức độ công bằng của một mô hình AI đối xử với các nhóm khác nhau là:

Sự khác biệt về tính chẵn lẻ thống kê—So sánh tỷ lệ kết quả thuận lợi giữa các nhóm. Kiểm tra này cho thấy dự đoán của mô hình không phụ thuộc vào tư cách thành viên nhóm nhạy cảm, hướng đến tỷ lệ lựa chọn ngang nhau giữa các nhóm. Nó hữu ích trong các trường hợp mong muốn tỷ lệ tích cực ngang nhau giữa các nhóm, chẳng hạn như tuyển dụng.

Chênh lệch tỷ lệ cược trung bình — So sánh sự chênh lệch giữa tỷ lệ dương tính giả và dương tính thật giữa các nhóm khác nhau. Chỉ số này nghiêm ngặt hơn Chênh lệch ngang bằng thống kê vì nó tìm cách đảm bảo tỷ lệ dương tính giả và dương tính thật bằng nhau giữa các nhóm. Chỉ số này hữu ích trong các trường hợp mà cả lỗi dương tính và lỗi âm tính đều có hậu quả, chẳng hạn như công lý hình sự.

Chênh lệch cơ hội bình đẳng — So sánh tỷ lệ dương tính thực giữa các nhóm khác nhau. Kiểm tra xem những cá nhân đủ điều kiện từ các nhóm khác nhau có cơ hội ngang nhau để được hệ thống AI lựa chọn hay không. Không tính đến tỷ lệ dương tính giả, có khả năng dẫn đến sự chênh lệch trong các dự đoán dương tính không chính xác giữa các nhóm.

Các nhà khoa học dữ liệu có thể tính toán các số liệu công bằng/thiên vị này trên các mô hình của họ bằng cách sử dụng thư viện Python như Microsoft Học tập công bằng gói hoặc IBM Công bằng AI 360 Bộ công cụ. Đối với tất cả các số liệu này, giá trị bằng không biểu thị kết quả công bằng về mặt toán học.

Để giảm thiểu sự thiên vị trong các tập dữ liệu đào tạo AI, những người xây dựng mô hình có một kho kỹ thuật tuyển chọn dữ liệu, có thể được chia thành định lượng (chuyển đổi dữ liệu bằng các gói toán học) và định tính (các phương pháp hay nhất để thu thập dữ liệu).

Thực hành định lượng

Xóa bỏ mối tương quan với các tính năng nhạy cảm

Ngay cả khi các đặc điểm nhạy cảm (ví dụ: chủng tộc, giới tính) bị loại khỏi quá trình đào tạo mô hình, các đặc điểm khác vẫn có thể tương quan với các đặc điểm nhạy cảm này và gây ra sự thiên vị. Ví dụ, mã bưu chính có mối tương quan mạnh với chủng tộc ở Hoa Kỳ. Để đảm bảo các đặc điểm này không gây ra sự thiên vị ẩn, các nhà khoa học dữ liệu nên xử lý trước các dữ liệu đầu vào của họ để loại bỏ mối tương quan giữa các đặc điểm đầu vào khác và các đặc điểm nhạy cảm.

Điều này có thể được thực hiện với Fairlearn’s CorrelationRemover chức năng. Nó chuyển đổi các giá trị đặc điểm về mặt toán học để loại bỏ mối tương quan trong khi vẫn giữ nguyên hầu hết giá trị dự đoán của các đặc điểm. Xem bên dưới để biết mã mẫu.

from fairlearn.preprocessing import CorrelationRemover

import pandas as pd

information = pd.read_csv('health_data.csv')

X = information(("patient_id", "num_chest_nodules", "insurance coverage", "hospital_code"))

X = pd.get_dummies(X)

cr = CorrelationRemover(sensitive_feature_ids=('insurance_None'))

cr.match(X)

X_corr_removed = cr.rework(X)

Sử dụng trọng số lại và lấy mẫu lại để tạo ra một mẫu cân bằng

Trọng số lại và lấy mẫu lại là những quy trình tương tự nhau tạo ra một tập dữ liệu đào tạo cân bằng hơn để hiệu chỉnh khi các nhóm cụ thể được biểu diễn dưới mức hoặc quá mức trong tập dữ liệu đầu vào. Trọng số lại liên quan đến việc gán các trọng số khác nhau cho các mẫu dữ liệu để đảm bảo rằng các nhóm được biểu diễn dưới mức có tác động tương xứng đến quy trình học của mô hình. Lấy mẫu lại liên quan đến việc lấy mẫu quá mức các trường hợp lớp thiểu số hoặc lấy mẫu quá ít các trường hợp lớp đa số để đạt được một tập dữ liệu cân bằng.

Nếu một nhóm nhạy cảm bị đại diện thiếu so với dân số nói chung, các nhà khoa học dữ liệu có thể sử dụng Sự cân nhắc lại của AI Fairness chức năng chuyển đổi dữ liệu đầu vào. Xem bên dưới để biết mã mẫu.

from aif360.algorithms.preprocessing import Reweighing

import pandas as pd

information = pd.read_csv('health_data.csv')

X = information(("patient_id", "num_chest_nodules", "insurance_provider", "hospital_code"))

X = pd.get_dummies(X)

rw = Reweighing(unprivileged_groups=('insurance_None'),

privileged_groups=('insurance_Aetna', 'insurance_BlueCross'))

rw.match(X)

X_reweighted = rw.rework(X)

Chuyển đổi các giá trị tính năng bằng cách sử dụng bộ loại bỏ tác động khác biệt

Một kỹ thuật khác để loại bỏ sai lệch nhúng trong dữ liệu đào tạo là chuyển đổi các tính năng đầu vào với một bộ loại bỏ tác động khác biệt. Kỹ thuật này điều chỉnh các giá trị tính năng để tăng tính công bằng giữa các nhóm được xác định bởi một tính năng nhạy cảm trong khi vẫn giữ nguyên thứ hạng của dữ liệu trong các nhóm. Điều này bảo toàn khả năng dự đoán của mô hình trong khi giảm thiểu sai lệch.

Để chuyển đổi các tính năng nhằm loại bỏ tác động không đồng đều, bạn có thể sử dụng Công cụ loại bỏ tác động không đồng đều của AI Fairness. Lưu ý rằng công cụ này chỉ chuyển đổi tính công bằng của dữ liệu đầu vào đối với một thuộc tính được bảo vệ duy nhất, do đó nó không thể cải thiện tính công bằng trên nhiều tính năng nhạy cảm hoặc tại giao điểm của các tính năng nhạy cảm. Xem bên dưới để biết mã mẫu.

from aif360.algorithms.preprocessing import disparate_impact_remover

import pandas as pd

information = pd.read_csv('health_data.csv')

X = information(("patient_id", "num_chest_nodules", "insurance_provider", "hospital_code"))

dr = DisparateImpactRemover(repair_level=1.0, sensitive_attribute='insurance_provider')

X_impact_removed = dr.fit_transform(X)

Tận dụng chú thích dữ liệu chuyên gia đa dạng để giảm thiểu sai lệch khi dán nhãn

Đối với các trường hợp sử dụng học có giám sát, việc gắn nhãn dữ liệu của con người đối với biến phản hồi thường là cần thiết. Trong những trường hợp này, người gắn nhãn dữ liệu không hoàn hảo của con người đưa thành kiến cá nhân của họ vào tập dữ liệu, sau đó được máy học. Điều này trở nên trầm trọng hơn khi các nhóm người gắn nhãn nhỏ, không đa dạng thực hiện chú thích dữ liệu.

Để giảm thiểu sự thiên vị trong quá trình chú thích dữ liệu, hãy sử dụng giải pháp chú thích dữ liệu chất lượng cao tận dụng các ý kiến chuyên gia đa dạng, chẳng hạn như Phòng thí nghiệm Centaur. Bằng cách tổng hợp nhiều ý kiến theo thuật toán sử dụng các biện pháp đánh giá theo tiêu chuẩn về độ tin cậy của nhãn, các giải pháp như vậy làm giảm tác động của sự thiên vị cá nhân và mang lại những bước tiến lớn trong độ chính xác của việc dán nhãn cho tập dữ liệu của bạn.

Thực hành định tính

Thực hiện các hoạt động thu thập dữ liệu mang tính bao hàm và đại diện

Dữ liệu đào tạo AI y tế phải có đủ kích thước mẫu trên tất cả các nhóm nhân khẩu học và tình trạng bệnh nhân để đưa ra dự đoán chính xác cho nhiều nhóm bệnh nhân khác nhau. Để đảm bảo các tập dữ liệu đáp ứng được những nhu cầu này, những người xây dựng ứng dụng nên hợp tác với các chuyên gia y tế và các bên liên quan có liên quan đại diện cho nhóm bệnh nhân bị ảnh hưởng để xác định các yêu cầu về dữ liệu. Các nhà khoa học dữ liệu có thể sử dụng lấy mẫu phân tầng để đảm bảo rằng tập đào tạo của họ không đại diện quá mức hoặc không đại diện cho các nhóm quan tâm.

Các nhà khoa học dữ liệu cũng phải đảm bảo rằng các kỹ thuật thu thập không làm sai lệch dữ liệu. Ví dụ, nếu thiết bị chụp ảnh y tế không nhất quán giữa các mẫu khác nhau, điều này sẽ dẫn đến sự khác biệt có hệ thống trong dữ liệu.

Đảm bảo các hoạt động làm sạch dữ liệu không gây ra sự thiên vị

Để tránh tạo ra sự thiên vị trong quá trình làm sạch dữ liệu, các nhà khoa học dữ liệu phải xử lý dữ liệu bị thiếu và tính toán giá trị một cách cẩn thận. Khi một tập dữ liệu có các giá trị bị thiếu cho một tính năng nhạy cảm như tuổi của bệnh nhân, các chiến lược đơn giản như tính toán độ tuổi trung bình có thể làm lệch dữ liệu, đặc biệt là nếu một số nhóm tuổi nhất định không được đại diện đầy đủ. Thay vào đó, các kỹ thuật như tính toán phân tầng, trong đó các giá trị bị thiếu được điền dựa trên phân phối trong các nhóm phụ có liên quan (ví dụ: tính toán trong phạm vi độ tuổi hoặc danh mục nhân khẩu học). Các phương pháp nâng cao như nhiều sự quy kếttạo ra một số giá trị hợp lý và tính trung bình chúng để tính đến sự không chắc chắn, cũng có thể phù hợp tùy thuộc vào tình huống. Sau khi thực hiện dọn dẹp dữ liệu, các nhà khoa học dữ liệu nên ghi lại quy trình tính toán và đảm bảo rằng tập dữ liệu đã dọn dẹp vẫn mang tính đại diện và không thiên vị theo các tiêu chuẩn được xác định trước.

Công bố các hoạt động quản lý để thu thập ý kiến đóng góp của các bên liên quan

Khi các nhà khoa học dữ liệu phát triển quy trình quản lý dữ liệu của mình, họ nên công bố chúng để các bên liên quan đóng góp ý kiến nhằm thúc đẩy tính minh bạch và trách nhiệm giải trình. Khi các bên liên quan (ví dụ: đại diện nhóm bệnh nhân, nhà nghiên cứu và chuyên gia đạo đức) xem xét và cung cấp phản hồi về các phương pháp quản lý dữ liệu, điều này giúp xác định và giải quyết các nguồn thiên vị tiềm ẩn ngay từ đầu quá trình phát triển. Hơn nữa, sự tham gia của các bên liên quan thúc đẩy sự tin tưởng và tự tin vào các hệ thống AI bằng cách thể hiện cam kết thực hiện các hoạt động đạo đức và toàn diện. Sự tin tưởng này rất cần thiết để thúc đẩy việc sử dụng các hệ thống AI sau khi triển khai.

Kiểm tra và xem xét thường xuyên dữ liệu đầu vào và hiệu suất mô hình

Kiểm toán và xem xét dữ liệu đầu vào cho các mô hình trực tiếp thường xuyên đảm bảo rằng sự thiên vị không phát triển trong các tập huấn luyện theo thời gian. Khi y học, đặc điểm nhân khẩu học của bệnh nhân và các nguồn dữ liệu phát triển, các mô hình trước đây không thiên vị có thể trở nên thiên vị nếu dữ liệu đầu vào không còn đại diện chính xác cho dân số hiện tại. Việc giám sát liên tục giúp xác định và sửa bất kỳ sự thiên vị mới nổi nào, đảm bảo mô hình vẫn công bằng và hiệu quả.

Các nhà khoa học dữ liệu phải thực hiện các biện pháp để giảm thiểu sự thiên vị trong các mô hình AI y tế của họ để đạt được kết quả công bằng cho bệnh nhân, thúc đẩy sự tham gia của các bên liên quan và đạt được sự chấp thuận của cơ quan quản lý. Các nhà khoa học dữ liệu có thể tận dụng các công cụ mới nổi từ các thư viện như Học tập công bằng (Microsoft) hoặc Bộ công cụ AI Fairness 360 (IBM) để đo lường và cải thiện tính công bằng trong các mô hình AI của họ. Mặc dù các công cụ và biện pháp định lượng như Statistical Parity Distinction rất hữu ích, nhưng các nhà phát triển phải nhớ áp dụng cách tiếp cận toàn diện đối với tính công bằng. Điều này đòi hỏi sự hợp tác với các chuyên gia và bên liên quan từ các nhóm bị ảnh hưởng để hiểu được nhóm bệnh nhân và tác động của các ứng dụng AI. Nếu các nhà khoa học dữ liệu tuân thủ theo thông lệ này, họ sẽ mở ra một kỷ nguyên mới về chăm sóc sức khỏe công bằng và vượt trội cho tất cả mọi người.

[ad_2]

Source link