[ad_1]

Bạn có thể đã từng nghe nói rằng một bức ảnh đáng giá hơn ngàn lời nói, nhưng liệu một mô hình ngôn ngữ lớn (LLM) có thể chụp được bức ảnh đó nếu nó chưa từng được nhìn thấy hình ảnh trước đây không?

Hóa ra, các mô hình ngôn ngữ được đào tạo hoàn toàn trên văn bản có hiểu biết vững chắc về thế giới hình ảnh. Họ có thể viết mã kết xuất hình ảnh để tạo ra những cảnh phức tạp với các đối tượng và bố cục hấp dẫn — và ngay cả khi kiến thức đó không được sử dụng đúng cách, LLM vẫn có thể tinh chỉnh hình ảnh của họ. Các nhà nghiên cứu từ Phòng thí nghiệm Khoa học Máy tính và Trí tuệ Nhân tạo (CSAIL) của MIT đã quan sát thấy điều này khi nhắc các mô hình ngôn ngữ tự sửa mã cho các hình ảnh khác nhau, trong đó hệ thống đã cải thiện các bản vẽ clipart đơn giản của chúng với mỗi truy vấn.

Kiến thức trực quan về các mô hình ngôn ngữ này có được từ cách mô tả các khái niệm như hình dạng và màu sắc trên web, cho dù bằng ngôn ngữ hay mã. Khi được đưa ra hướng dẫn như “vẽ một con vẹt trong rừng”, người dùng sẽ chạy LLM để xem xét những gì nó đã đọc trong phần mô tả trước đó. Để đánh giá mức độ kiến thức về hình ảnh của LLM, nhóm CSAIL đã xây dựng một “kiểm tra thị lực” cho LLM: bằng cách sử dụng “Bộ dữ liệu năng lực thị giác”, họ đã kiểm tra khả năng vẽ, nhận biết và tự sửa các khái niệm này của mô hình. Thu thập từng bản thảo cuối cùng của những hình minh họa này, các nhà nghiên cứu đã đào tạo một hệ thống thị giác máy tính để xác định nội dung của những bức ảnh thật.

Tamar Rott Shaham, đồng tác giả chính của nghiên cứu, cho biết: “Về cơ bản, chúng tôi đào tạo một hệ thống thị giác mà không sử dụng trực tiếp bất kỳ dữ liệu hình ảnh nào”. học và một postdoc về kỹ thuật điện và khoa học máy tính (EECS) của MIT tại CSAIL. “Nhóm của chúng tôi đã truy vấn các mô hình ngôn ngữ để viết mã kết xuất hình ảnh nhằm tạo dữ liệu cho chúng tôi, sau đó đào tạo hệ thống thị giác để đánh giá hình ảnh tự nhiên. Chúng tôi lấy cảm hứng từ câu hỏi về cách thể hiện các khái niệm trực quan thông qua các phương tiện khác, như văn bản. Để thể hiện kiến thức trực quan của mình, LLM có thể sử dụng mã làm điểm chung giữa văn bản và hình ảnh.”

Để xây dựng tập dữ liệu này, trước tiên, các nhà nghiên cứu đã truy vấn các mô hình để tạo mã cho các hình dạng, đối tượng và cảnh khác nhau. Sau đó, họ biên dịch mã đó để hiển thị các hình minh họa kỹ thuật số đơn giản, chẳng hạn như một hàng xe đạp, cho thấy LLM hiểu rõ các mối quan hệ không gian để vẽ xe hai bánh thành một hàng ngang. Một ví dụ khác, mô hình đã tạo ra một chiếc bánh hình ô tô, kết hợp hai khái niệm ngẫu nhiên. Mô hình ngôn ngữ còn tạo ra một bóng đèn phát sáng, cho thấy khả năng tạo hiệu ứng hình ảnh của nó.

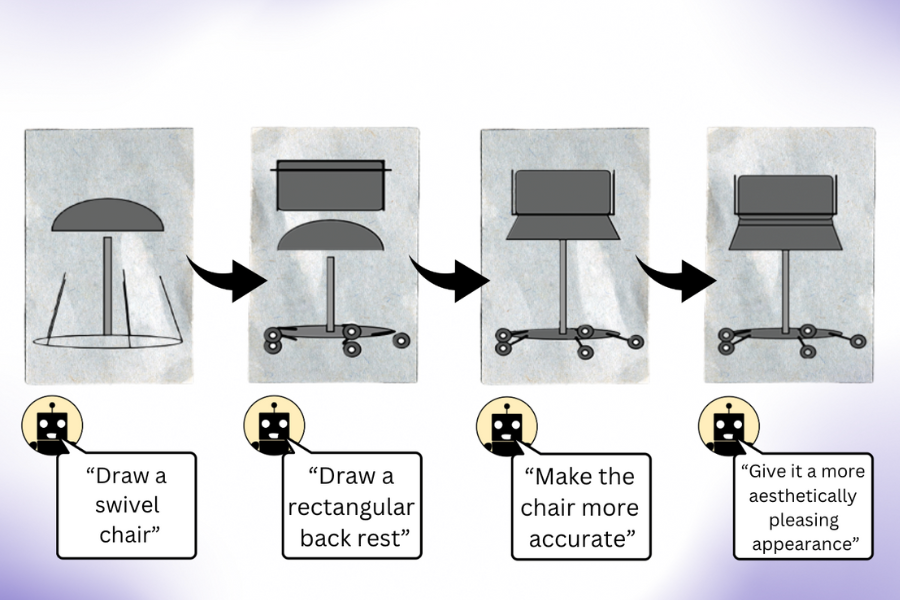

Pratyusha Sharma, đồng tác giả chính, nghiên cứu sinh tiến sĩ EECS và thành viên CSAIL, Pratyusha Sharma cho biết: “Công việc của chúng tôi cho thấy rằng khi bạn truy vấn LLM (không được đào tạo trước đa phương thức) để tạo một hình ảnh, nó biết nhiều hơn những gì bạn tưởng”. “Giả sử bạn yêu cầu nó vẽ một cái ghế. Mô hình biết những điều khác về món đồ nội thất này mà nó có thể chưa hiển thị ngay lập tức, vì vậy người dùng có thể truy vấn mô hình để cải thiện hình ảnh mà nó tạo ra sau mỗi lần lặp. Điều đáng ngạc nhiên là mô hình có thể lặp đi lặp lại làm phong phú bản vẽ bằng cách cải thiện mã kết xuất ở mức độ đáng kể.”

Các nhà nghiên cứu đã thu thập những hình minh họa này, sau đó được sử dụng để huấn luyện hệ thống thị giác máy tính có thể nhận dạng các vật thể trong ảnh thật (mặc dù chưa từng nhìn thấy vật thể nào trước đây). Với dữ liệu tổng hợp, được tạo bằng văn bản này làm điểm tham chiếu duy nhất, hệ thống sẽ hoạt động tốt hơn các bộ dữ liệu hình ảnh được tạo theo quy trình khác đã được đào tạo bằng ảnh xác thực.

Nhóm CSAIL tin rằng việc kết hợp kiến thức trực quan tiềm ẩn của LLM với khả năng nghệ thuật của các công cụ AI khác như mô hình khuếch tán cũng có thể mang lại lợi ích. Các hệ thống như Midjourney đôi khi thiếu bí quyết để điều chỉnh nhất quán các chi tiết đẹp hơn trong hình ảnh, khiến chúng khó xử lý các yêu cầu như giảm số lượng ô tô trong hình hoặc đặt một vật thể phía sau một vật thể khác. Nếu LLM phác thảo trước thay đổi được yêu cầu đối với mô hình khuếch tán thì kết quả chỉnh sửa có thể hài lòng hơn.

Điều trớ trêu, như Rott Shaham và Sharma thừa nhận, là LLM đôi khi không nhận ra được những khái niệm giống nhau mà họ có thể vẽ ra. Điều này trở nên rõ ràng khi các mô hình xác định không chính xác việc tái tạo hình ảnh của con người trong tập dữ liệu. Những cách thể hiện đa dạng như vậy về thế giới thị giác có thể đã gây ra quan niệm sai lầm của các mô hình ngôn ngữ.

Trong khi các người mẫu gặp khó khăn trong việc cảm nhận những mô tả trừu tượng này, họ đã thể hiện khả năng sáng tạo để vẽ những khái niệm giống nhau một cách khác nhau mỗi lần. Khi các nhà nghiên cứu yêu cầu LLM vẽ các khái niệm như quả dâu tây và mái vòm nhiều lần, họ đã tạo ra các bức tranh từ nhiều góc độ khác nhau với hình dạng và màu sắc khác nhau, gợi ý rằng các mô hình có thể có hình ảnh thực tế trong đầu về các khái niệm thị giác (thay vì trích dẫn các ví dụ mà họ đã thấy trước đó).

Nhóm CSAIL tin rằng quy trình này có thể là cơ sở để đánh giá mức độ hiệu quả của mô hình AI tổng quát có thể huấn luyện hệ thống thị giác máy tính. Ngoài ra, các nhà nghiên cứu tìm cách mở rộng các nhiệm vụ mà họ thách thức các mô hình ngôn ngữ. Đối với nghiên cứu gần đây của họ, nhóm MIT lưu ý rằng họ không có quyền truy cập vào bộ đào tạo LLM mà họ đã sử dụng, khiến việc điều tra sâu hơn về nguồn gốc kiến thức thị giác của họ trở nên khó khăn. Trong tương lai, họ dự định khám phá việc đào tạo một mô hình thị giác tốt hơn nữa bằng cách để LLM làm việc trực tiếp với nó.

Sharma và Rott Shaham tham gia giấy bởi cựu chi nhánh CSAIL Stephanie Fu ’22, MNG ’23 và các nghiên cứu sinh tiến sĩ EECS Manel Baradad, Adrián Rodríguez-Muñoz ’22, và Shivam Duggal, tất cả đều là chi nhánh của CSAIL; cũng như Phó Giáo sư Phillip Isola của MIT và Giáo sư Antonio Torralba. Công việc của họ được hỗ trợ một phần bởi khoản trợ cấp từ Phòng thí nghiệm AI Watson của MIT-IBM, Học bổng LaCaixa, Chương trình Lãnh đạo STEM của Zuckerman và Học bổng Viterbi. Họ trình bày bài báo của mình trong tuần này tại Hội nghị nhận dạng mẫu và thị giác máy tính IEEE/CVF.

[ad_2]

Source link