[ad_1]

Tiếp nối câu chuyện của Zephyra, Anthropic AI đã đi sâu vào cuộc thám hiểm trích xuất các đặc điểm có ý nghĩa trong một mô hình. Ý tưởng đằng sau cuộc điều tra này nằm ở việc hiểu cách các thành phần khác nhau trong mạng lưới thần kinh tương tác với nhau và vai trò của mỗi thành phần.

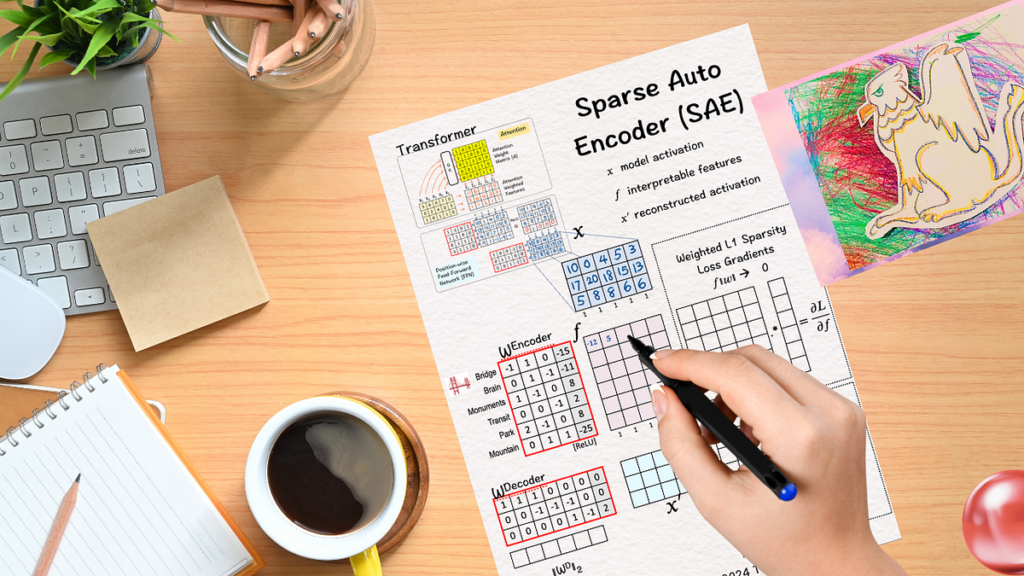

Theo bài báo “Hướng tới tính đơn nghĩa: Phân tách các mô hình ngôn ngữ bằng cách học từ điển” Bộ mã hóa tự động thưa thớt có thể trích xuất thành công các tính năng có ý nghĩa từ một mô hình. Nói cách khác, Bộ mã hóa tự động thưa thớt giúp giải quyết vấn đề về ‘tính đa ngữ nghĩa’ — các kích hoạt thần kinh tương ứng với nhiều ý nghĩa/cách hiểu cùng một lúc bằng cách tập trung vào các tính năng kích hoạt thưa thớt có một cách diễn giải duy nhất — nói cách khác, mang tính một chiều hơn.

Để hiểu cách thực hiện tất cả, chúng tôi có những tác phẩm thủ công tuyệt đẹp này Bộ mã hóa tự động Và Bộ mã hóa tự động thưa thớt bởi Giáo sư Tom Yeh giải thích hoạt động đằng sau hậu trường của những cơ chế phi thường này.

(Tất cả các hình ảnh bên dưới, trừ khi có ghi chú khác, là của Giáo sư Tom Yeh từ các bài đăng trên LinkedIn nêu trên mà tôi đã chỉnh sửa với sự cho phép của ông.)

Để bắt đầu, trước tiên chúng ta hãy khám phá Bộ mã hóa tự động là gì và cách thức hoạt động của nó.

Hãy tưởng tượng một nhà văn có bàn làm việc ngổn ngang nhiều loại giấy tờ khác nhau – một số là ghi chú cho câu chuyện anh ấy đang viết, một số là bản sao của bản thảo cuối cùng, một số lại là minh họa cho câu chuyện đầy hành động của anh ấy. Giờ đây, giữa sự hỗn loạn này, thật khó để tìm được những phần quan trọng – càng khó hơn khi người viết đang vội và nhà xuất bản gọi điện thoại yêu cầu xuất bản một cuốn sách trong hai ngày tới. Rất could, người viết có một trợ lý rất hiệu quả – người trợ lý này đảm bảo chiếc bàn bừa bộn được dọn dẹp thường xuyên, nhóm các đồ vật giống nhau, sắp xếp và đặt mọi thứ vào đúng vị trí. Và khi cần thiết, người trợ lý sẽ lấy đúng tài liệu cho người viết, giúp anh ta đáp ứng thời hạn do nhà xuất bản đặt ra.

À, tên của trợ lý này là Autoencoding. Nó chủ yếu có hai chức năng – mã hóa và giải mã. Mã hóa đề cập đến việc cô đọng dữ liệu đầu vào và trích xuất các tính năng (tổ chức) thiết yếu. Giải mã là quá trình xây dựng lại dữ liệu gốc từ biểu diễn được mã hóa nhằm mục đích giảm thiểu mất mát thông tin (truy xuất).

Bây giờ hãy xem trợ lý này hoạt động như thế nào.

Cho: Bốn ví dụ huấn luyện X1, X2, X3, X4.

(1) Ô tô

Bước đầu tiên là sao chép các ví dụ huấn luyện vào mục tiêu Y’. Công việc của Bộ mã hóa tự động là xây dựng lại các ví dụ huấn luyện này. Vì mục tiêu chính là các ví dụ huấn luyện nên từ ‘Tự động’ được sử dụng trong tiếng Hy Lạp cho ‘bản thân’.

(2) Bộ mã hóa: Lớp 1 +ReLU

Như chúng ta đã thấy trong tất cả các mô hình trước đây, ma trận trọng số và độ lệch đơn giản kết hợp với ReLU rất mạnh mẽ và có thể làm nên điều kỳ diệu. Do đó, bằng cách sử dụng lớp Mã hóa đầu tiên, chúng tôi giảm kích thước của bộ tính năng ban đầu từ 4×4 xuống 3×4.

Tóm tắt nhanh:

Chuyển đổi tuyến tính : Vectơ nhúng đầu vào được nhân với ma trận trọng số W rồi cộng với vectơ thiên vị b,

z = Wx+bỞ đâu W là ma trận trọng số, x là từ nhúng của chúng tôi và b là vectơ thiên vị.

Chức năng kích hoạt ReLU : Tiếp theo, chúng tôi áp dụng ReLU cho z trung gian này.

ReLU trả về giá trị tối đa theo phần tử của đầu vào và bằng 0. Về mặt toán học, h = tối đa{0,z}.

(3) Bộ mã hóa: Lớp 2 + ReLU

Đầu ra của lớp trước được xử lý bởi lớp Bộ mã hóa thứ hai, giúp giảm kích thước đầu vào xuống còn 2×3. Đây là nơi xảy ra việc trích xuất các tính năng liên quan. Lớp này còn được gọi là ‘nút thắt cổ chai’ vì các đầu ra của lớp này có các tính năng thấp hơn nhiều so với các tính năng đầu vào.

(4) Bộ giải mã : Lớp 1 + ReLU

Sau khi quá trình mã hóa hoàn tất, bước tiếp theo là giải mã các tính năng liên quan để xây dựng “again” đầu ra cuối cùng. Để làm như vậy, chúng tôi nhân các tính năng từ bước cuối cùng với các trọng số và độ lệch tương ứng rồi áp dụng lớp ReLU. Kết quả là một ma trận 3×4.

(5) Bộ giải mã : Lớp 2 + ReLU

Lớp Bộ giải mã thứ hai (trọng số, độ lệch + ReLU) áp dụng trên đầu ra trước đó để đưa ra kết quả cuối cùng là ma trận 4×4 được xây dựng lại. Chúng tôi làm như vậy để quay lại kích thước ban đầu nhằm so sánh kết quả với mục tiêu ban đầu của chúng tôi.

(6) Độ dốc mất & Truyền ngược

Sau khi thu được đầu ra từ lớp giải mã, chúng tôi tính toán độ dốc của Sai số bình phương trung bình (MSE) giữa đầu ra (Y) và mục tiêu (Y’). Để làm như vậy, chúng tôi tìm thấy 2*(Y-Y’) nó cung cấp cho chúng ta các gradient cuối cùng kích hoạt quá trình lan truyền ngược và cập nhật các trọng số và độ lệch tương ứng.

Bây giờ chúng ta đã hiểu cách Bộ mã hóa tự động hoạt động, đã đến lúc khám phá cách thức hoạt động của nó. biến thể thưa thớt có thể đạt được khả năng diễn giải cho các mô hình ngôn ngữ lớn (LLM).

Để bắt đầu, giả sử chúng ta được cho:

- Đầu ra của máy biến áp sau khi lớp chuyển tiếp nguồn cấp dữ liệu đã xử lý nó, tức là giả sử chúng ta có kích hoạt mô hình cho năm mã thông báo (X). Chúng tốt nhưng chúng không làm sáng tỏ cách mô hình đi đến quyết định hoặc đưa ra dự đoán.

Câu hỏi chính ở đây là:

Có thể ánh xạ từng kích hoạt (3D) sang không gian có chiều cao hơn (6D) để giúp hiểu rõ hơn không?

(1) Bộ mã hóa: Lớp tuyến tính

Bước đầu tiên trong lớp Mã hóa là nhân dữ liệu đầu vào X với trọng số của bộ mã hóa và thêm độ lệch (như được thực hiện trong bước đầu tiên của Bộ mã hóa tự động).

(2) Bộ mã hóa: ReLU

Bước phụ tiếp theo là áp dụng chức năng kích hoạt ReLU để thêm tính phi tuyến tính và ngăn chặn các kích hoạt tiêu cực. Việc loại bỏ này dẫn đến nhiều tính năng được đặt thành 0, điều này cho phép khái niệm về độ thưa thớt – xuất ra các tính năng thưa thớt và có thể hiểu được f.

Khả năng diễn giải xảy ra khi chúng ta chỉ có một hoặc hai đặc điểm tích cực. Nếu chúng ta kiểm tra f6chúng ta có thể nhìn thấy X2 Và X3 là tích cực và có thể nói rằng cả hai đều có điểm chung là ‘Núi’.

(3) Bộ giải mã : Tái thiết

Sau khi hoàn tất bộ mã hóa, chúng ta tiến hành bước giải mã. Chúng tôi nhân lên f với trọng số bộ giải mã và thêm độ lệch. Đầu ra này X’đó là sự tái thiết của X từ những đặc điểm có thể giải thích được.

Như đã thực hiện trong Bộ mã hóa tự động, chúng tôi muốn X’ được gần gũi như vậy X càng tốt. Để đảm bảo điều đó, việc đào tạo thêm là điều cần thiết.

(4) Bộ giải mã : Trọng số

Là một bước trung gian, chúng tôi tính toán định mức L2 cho từng trọng số trong bước này. Chúng tôi giữ chúng sang một bên để sử dụng sau này.

L2-định mức

Còn được gọi là chuẩn Euclide, L2-norm tính toán độ lớn của vectơ bằng công thức: ||x||₂ = √(Σᵢ xᵢ²).

Nói cách khác, nó tính tổng bình phương của từng thành phần và sau đó lấy căn bậc hai của kết quả. Định mức này cung cấp một cách đơn giản để định lượng độ dài hoặc khoảng cách của vectơ trong không gian Euclide.

Như đã đề cập trước đó, Bộ mã hóa tự động thưa thớt sẽ tiến hành đào tạo chuyên sâu để có được cấu trúc được xây dựng lại X’ gần hơn với X. Để minh họa điều đó, chúng tôi tiến hành các bước tiếp theo dưới đây:

(5) Độ thưa thớt : Mất L1

Mục tiêu ở đây là thu được càng nhiều giá trị càng gần 0/0 càng tốt. Chúng tôi làm như vậy bằng cách gọi L1 thưa thớt để trừng phạt các giá trị tuyệt đối của các trọng số – ý tưởng cốt lõi là chúng ta muốn làm cho tổng càng nhỏ càng tốt.

L1-mất

Tổn thất L1 được tính bằng tổng các giá trị tuyệt đối của các trọng số: L1 = λΣ|w|, trong đó λ là tham số chính quy hóa.

Điều này khuyến khích nhiều trọng số trở thành 0, đơn giản hóa mô hình và do đó nâng cao khả năng diễn giải.

Nói cách khác, L1 giúp xây dựng sự tập trung vào các tính năng phù hợp nhất đồng thời ngăn ngừa tình trạng trang bị quá mức, cải thiện khả năng khái quát hóa mô hình và giảm độ phức tạp tính toán.

(6) Độ thưa thớt: Độ dốc

Bước tiếp theo là tính toán L1độ dốc của -1 cho các giá trị dương. Như vậy, với mọi giá trị của f >0 kết quả sẽ được đặt thành -1.

[ad_2]

Source link